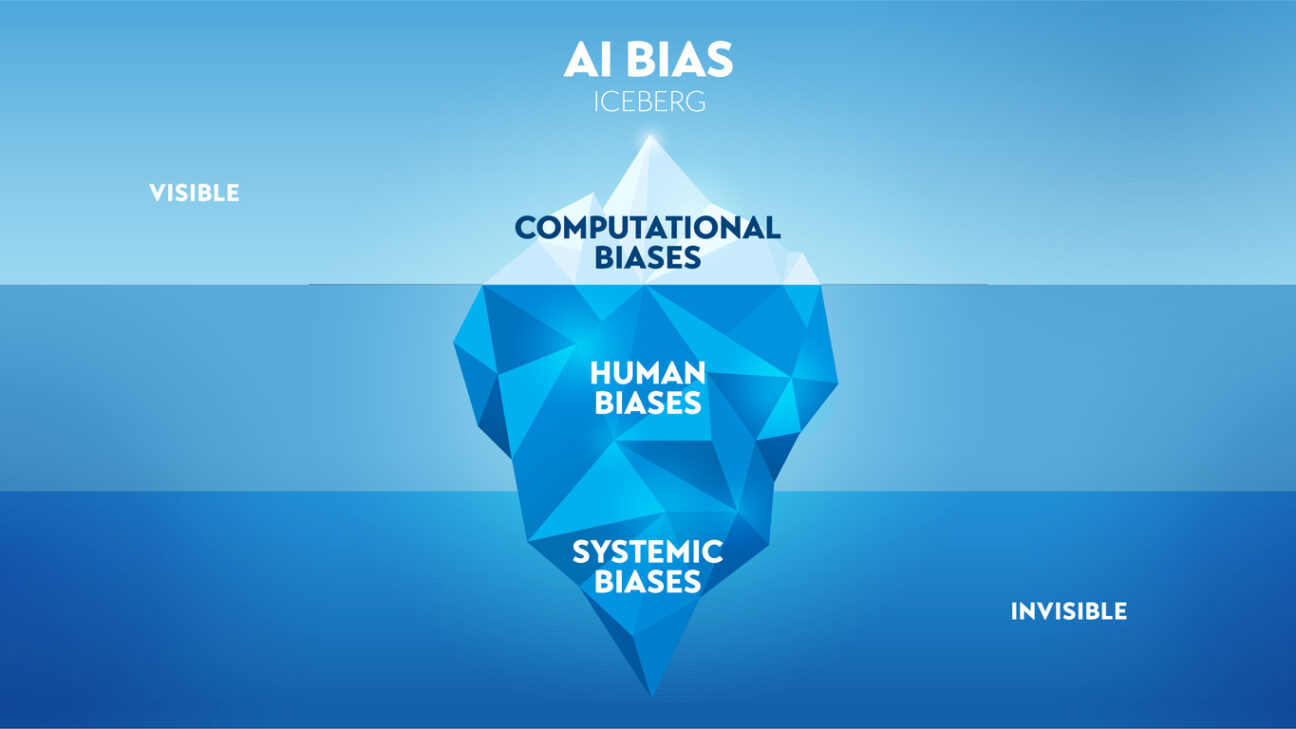

I den bästa av världar kan AI hjälpa till att skapa mångfald och rättvisa – att representera hela populationen och fatta beslut baserat på fakta utan påverkan av omedvetna fördomar. Frågan är bara hur datapunkter och algoritmer använts för att motverka bias?

Algoritmer i AI är en produkt av mänsklig design och vi behöver därför vara uppmärksamma på om AI ärver våra fördomar och tankefällor. Det kan finnas en risk med att AI vidmakthåller mänskliga fördomar och social ojämlikhet. Data som inte representerar mångfalden av den verklighet som AI ska tillämpas på kan ge oönskade effekter. En studie i tidningen Nature visar att det kan finnas risk för att vi människor är allt för okritiska till AI och att AI ärver våra misstag och fördomar. Studien visar också på det motsatta förhållandet; att det finns risk att vi människor ärver fördomar från AI och att dessa förstärks. Det kan också finnas en risk kring ”the black-box dilemma”, d v s att tekniken och metoderna är allt för komplexa och utan transparens vilket gör att minoritetsgrupper som är underrepresenterade i algoritmer blir svåra att upptäcka.

5 frågor att ställa:

- Hur transparent är tekniken och vald metod? Finns möjlighet att förstå vilken data som samlats in och vilka begränsningar som finns?

- Hur är mångfald definierad?

- Hur mäts mångfald?

- Finns bias detection tools?

- Har vi ett kritiskt öga och förståelse för att fördomar finns och att problem kan uppstå?

Mycket fokus ligger på ägarskap och ansvar. Vem som bär ansvar för algoritmer och etik. Att nå resultat i arbetet med mångfald och inkludering har visat sig vara en förvånansvärt tidskrävande resa i mänskliga beteenden och svår nöt att knäcka. ”Bias detection tools” finns och utvecklas men vi får nog räkna med att det kan ta tid att uppnå jämställdhet även inom AI.

https://www.nature.com/articles/s41598-023-42384-8

https://www.ibm.com/blog/shedding-light-on-ai-bias-with-real-world-examples/